Was noch zu bedenken ist…

Im Folgenden einige praxisnahe Hinweise aus dem täglichen Umgang mit analoger Messtechnik:

- Bei der Verifizierung analoger Messungen von höherer Genauigkeit spielt Temperatur eine große Rolle. Insbesondere sind viele (alle?) elektronischen Prozesse mehr oder weniger temperaturabhängig. Geräteseitig wird dabei mitunter erheblicher Aufwand betrieben diese Temperaturabhängigkeit zu reduzieren.

Trotzdem sollten sich sowohl Quellen (Netzteile, PowerSupply, Sensoren) wie auch Messgeräte (EtherCAT Klemme, Referenzgeräte) vor Benutzung thermisch stabilisiert haben (siehe entsprechende Dokumentation), oft sind hier Zeitbereiche von >30 Minuten gefordert.

Temperaturänderungen können insbesondere bei Langzeitmessungen >1h verfälschenden Einfluss auf die protokollierten Daten haben.

Als Beispiele für (versteckten) Temperatureinfluss wären zu nennen: - initiale Geräteerwärmung nach dem Einschalten,

- Zugluft, Wärmeabstrahlung naher Geräte/Menschen, Strahlungseinwirkung z.B. durch Sonne (auch im nicht sichtbaren Bereich!),

- veränderlicher Betrieb der Raumklimaanlage

- Veränderung der Einbaulage/benachbarter Klemmen.

- Veränderung der internen Belastung (Stromfluss, Spannungshöhe)

- Handgehaltene Verbindungen (Stecker)

- Diese Temperaturabhängigkeit trifft insbesondere auf die zu vermessende Last/Quelle/Sensor zu, z.B. eine DMS-Vollbrücke die zum Test angeschlossen wird. Wird z.B. eine Vollbrücke aus einfachen Widerständen nachgebildet, hat diese Konstruktion einen Temperaturkoeffizienten, der weit über dem des Messgeräts (Beckhoff Klemme/Box) liegt. Aber auch die Spannung einer einfachen Batteriezelle zeigt eine erhebliche Temperaturabhängigkeit!

- Stromeingänge können einen stromabhängigen Innenwiderstand haben. Deshalb kann eine Ansteuerung mit einem spannungs-kontrollierten Signal (z.B. Netzteil) zu irreführenden Ergebnissen führen.

- Einflüsse auf die Signalleitungen aus elektrodynamischer/magnetischer Abstrahlung sind zu beachten – es sind entsprechende Abschirmung/Erdung/Schutzkomponenten vorzusehen. Dies wird umso wichtiger, je kleiner (Amplitude) die transportierten Signale werden: analoge Pegel im Bereich < 10 V und dann ganz besonders mV und µV (Thermoelemente, Messbrücken/DMS) und mA/µA müssen geschützt werden durch wirkungsvolle Schirmung, ggf. paarig verdrillte Leitungen, Leitungsführung mit Abstand zu Hochspannungs-/Hochstromleitungen.

Siehe dazu insbes. in dieser Dokumentation das Kapitel Analogtechnische Hinweise - Schirm und Erde. - Bei Tests zum Verhalten unter wechselnden Signalamplituden ist auch das Verhalten der Quelle unter wechselnder Last (= Lastabwurf, Lastzuschaltung, Pegelanpassung) zu beachten.

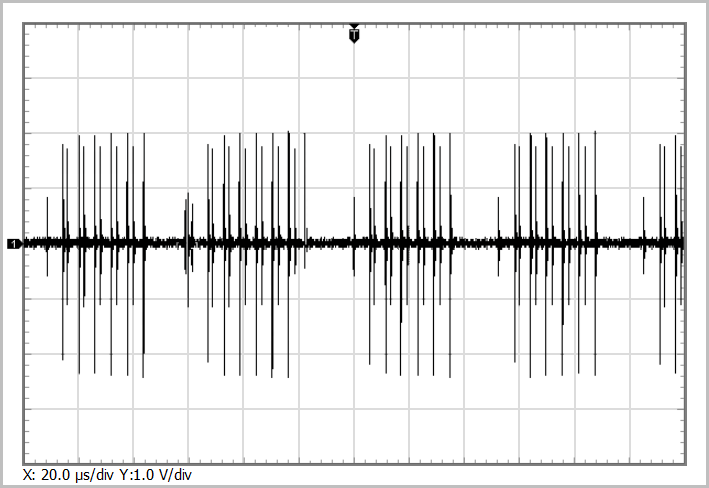

Achtung, die Belastung des Sensors wechselt ggf., auch, wenn im Messgerät (Klemme, Box) Selbsttestroutinen ablaufen. - Bei der testweisen/Labormäßigen Verwendung von Kalibratoren (= Geräte die lt. Display eine Soll-Spannung/Strom/… ausgeben) ist das begleitende Mitmessen mit hochwertigen Messgeräten (Multimeter) sehr zu empfehlen. Wenn nicht ausdrücklich sichergestellt ist daß die spezifische Kombination aus Kalibrator (Quelle) <-> Beckhoff Analogeingang (Senke: Klemme, Box) harmoniert, ist dem Anzeigewert des Kalibrators zu mißtrauen! Die für industriellen Einsatz nötigen EMV-Schutzbeschaltungen in den Beckhoff Produkten können zu Oszillationen und Pump-Effekten führen, die das „wahre“ Signal auf der Leitung verändern und in Widerspruch zum Kalibrator-Displaywert bringen, wenn dieser keine eigene Rückmessfunktion hat. Klärung kann ein analytischer Blick mit dem Oszilloskop oder der Einsatz verschiedener Kalibratoren bringen.

- Generell ist es empfehlenswert Herstellerangaben zur verwendeten Last/Quelle/Sensor z.B. bezüglich letzter Justage, thermisches Verhalten usw. zu beachten.

- Zum Beispiel ist die Angabe über das Eigenrauschen der Quelle zu beachten, wenn damit das angegebene Rauschen der Beckhoff Geräte überprüft werden soll. Solche Rauschangaben sind allerdings nur bei höherwertigen Quellen zu finden.

- Es ist der Unterschied Kalibrierung vs. Justage/Abgleich zu beachten. Eine kürzlich erfolgte Kalibrierung (= Feststellung der verbleibenden Abweichung gegenüber vertrauenswürdigem Normal) an sich hat nur Bedeutung, wenn das Gerät dabei innerhalb der herstellerseitig zugesicherten Toleranz gemessen hat bzw. durch eine Justage/Abgleich entsprechend eingestellt wurde. Der nach Justage verbleibende Restfehler, der dann im Kalibrierzertifikat kundgetan wird, ist ggf. händisch zu berücksichtigen.

- Viele elektrische Messungen aus Sensor und Messgerät unterliegen einem initialen elektrischen Offset, der ggf. die Messung stark beeinträchtig. Beispiele sind Null-Last einer Waage (Lösung: Tara) oder auch bei einer Spannungsmessung Ruhespannungen in den Leitungen. Gerade aber nicht nur bei DMS-Messungen ist es hilfreich eine Offset-Korrektur zeitnah vor der echten Messung durchzuführen, da insbesondere auch der Offset-Anteil des Messkanals der Klemme selbst (siehe Kap. Spezifikation) erheblich reduziert wird.

- Falls die Klemme nach Transport/Lagerung Kondensation ausgesetzt war, ist sie so lange spannungsfrei zu lagern, bis sie vollständig trocken ist.

- Fallweise vorhandene Lüftungsöffnungen sind großzügig für die freie Konvektion freizuhalten. Siehe Abstandsempfehlungen im Kapitel „Montage und Verdrahtung“.

- Bei hochgenauen Messungen können störende Einflüsse durch Thermospannungen im mV/µV-Bereich auftreten. Konkret kann dies bei Verwendung von Aderendhülsen auf Kupfer-Litze am Klemmstellenkontakt der Klemme auftreten, da hier der Punkt der unterschiedlichen Materialpaarung örtlich verschoben wird. Eventuell kann in solchen Fällen das direkte Einstecken der Litze in den Klemmkontakt oder eine Kontaktreinigung versucht werden.

- Bei Messungen mit Strömen > 100 µA z.B. 20-mA-Stromschleife sind lose Verbindungen z.B. handgehaltene Messpitzen keinesfalls zulässig! Sie führen zu stark und schnell schwankenden Übergangswiderständen die i.d.R. von der Stromquelle nicht entsprechend schnell ausgeregelt werden können. Jegliche Verbindungen sind kontaktsicher zu klemmen/schrauben/löten.

Nebenbei: handgehaltene Prüfspitzen können sich dadurch erwärmen und zu veränderlicher Thermospannung führen

- Zwei Aspekte bei Verwendung von Signalgeneratoren als Signalgeber, insbesondere bei ersten Messversuchen mit analogen Klemmen oder bei Filter-Versuchen:

- Die Amplitude des Ausgabesignals bricht mit steigender Frequenz oft ein. Wenn also 1 Vpp als Soll-Amplitude eingestellt sind, wird diese bei „langsamen“ Signalen <100 Hz (geräteabhängig!) meist noch sauber erreicht, bei >100 Hz aber nicht mehr. Das wird dann als scheinbarer Messfehler des analogen Eingangs gedeutet da dieser den realen Pegel misst. Es wird dringend empfohlen nicht der grafischen Anzeige des Signalgenerators zu trauen, sondern das Ausgabesignal mit einem dritten Gerät nachzumessen, idealerweise einem bewährten Oszilloskop. Ggf. muss die Amplitude am Signalgenerator manuell frequenzabhängig überhöht werden, bis das Gerät an seine Aussteuergrenze kommt.

- Signalgeneratoren mit grafischer Anzeige (Bildschirm) lassen sich einfach einstellen, geben jedoch lediglich ein „soll“ Ausgabesignal vor, dass u.U. nicht unbedingt dem tatsächlichen messbaren „ist“ Signal entspricht. Mitursächlich dafür können die Impedanz-Einstellung des Ausgangs und der Massebezug sein.

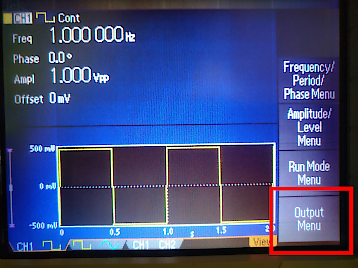

Beispiel: ein Tektronix AFG3022B Signalgenerator wird an Kanal 1 2‑polig/differentiell mit einer ELM3004 im ±10 V Betrieb verbunden und ein Signal 1 Vpp, 1 Hz eingestellt.

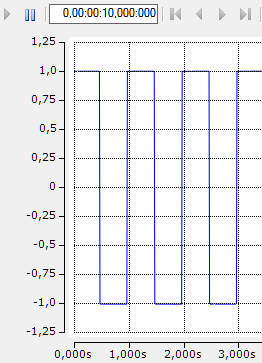

Tatsächlich sieht die Klemme aber 2 Vpp, im Folgenden durch eine zugehörige TwinCAT Scope Ausgabe dargestellt:

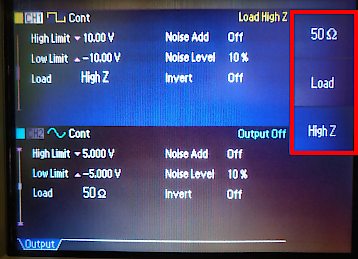

Ursächlich für die „falsche“ Anzeige des Signalgenerators ist seine Ausgangseinstellung „50 Ω“ oder auch „Load“, d.h. er geht von einer leistungsangepassten Pegelanpassung und somit auch von 50 Ω auf der Eingangsseite aus.

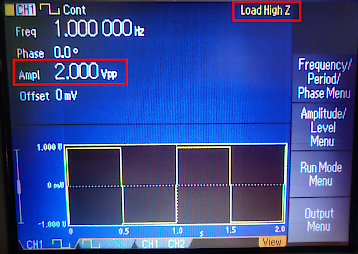

Industrielle Analogklemmen haben aber i.d.R. Eingangswiderstände von einigen 100 kΩ bis MΩ. Deshalb ist die Impedanz-Einstellung „HighZ“ in diesem Fall die richtige:

Elektrisch hat sich das Ausgangssignal während der Umstellung nicht verändert! Es verändert sich lediglich die Anzeige im Bildschirm.

Auch hier wird empfohlen, vor Versuchsbeginn das Ausgabesignal mit einem dritten Gerät nachzumessen, einem Multimeter oder Oszilloskop. Für diesen Test ist kein dynamisches Signal [kHz] nötig, es reicht ein DC oder langsames AC‑Signal.

- Ein paar grundlegende Gedanken zu Auflösung vs. Genauigkeit/Messunsicherheit:

Oft werden analoge Messungen mit hoher Auflösung (z.B. 24 Bit) gefordert, wo eigentlich eine niedrige Messunsicherheit = hohe Messgenauigkeit (z.B. ±0,005 % vom Messbereichsendwert) gewünscht wird. Implizit wird angenommen, dass eine Messung mit hoher Auflösung immer automatisch auch eine niedrige Messunsicherheit mit sich bringt. Beide Eigenschaften sind jedoch zunächst unabhängig voneinander.

Die Auflösung quantifiziert die Intervallgröße, welche zu einer digitalen Unterscheidbarkeit im Messergebnis führt, z.B. eine Änderung von 20 mV im Analogsignal wird nur erfasst, wenn auch die Auflösung kleiner als 20 mV ist, wobei die Auflösung technisch durch die Referenzspannung und die Anzahl der Bits bestimmt ist. Das ist aber noch unabhängig davon, inwiefern der auflösbare Wert dem wahren Wert entspricht.

Grundsätzlich gilt: Auflösung resultiert aus dem Schaltungsdesign, niedrige Messunsicherheit/hohe Genauigkeit (vor allem) aus dem Abgleich – wobei beide Felder anspruchsvoll sind.

Es existieren verschiedene Einflussfaktoren, die die Messgenauigkeit verschlechtern:

Ist ein Einflussfaktor bekannt und beschreibbar, ist dieser der systematischen Messunsicherheit zuzuordnen. Beispielsweise ist ein Temperatur- oder Kennlinien-Einfluss quantifizierbar und dann i.d.R. im Produktionsabgleich oder zur Betriebszeit zu kompensieren, der resultierende Aufwand kann hierbei durch geschicktes Design verringert werden.

Den anderen wesentlichen Einfluss auf die effektive Messgenauigkeit haben zufällige Einflussgrößen: das Eigenrauschen der Elektronik, sowie weitere in der gesamten Messkette. Diese Messunsicherheiten zeichnen sich dadurch aus daß sie deterministisch nicht beschreibbar sind und die Abweichung der Messergebnisse von Messung zu Messung rein zufälliger Natur ist. Hier hat der Anwender einen großen Handlungsspielraum, denn durch Mittelwertbildung über mehrere Messungen kann die Messgenauigkeit des verrechneten Ergebnisses gesteigert werden. Denn echt zufällige Schwankungen gelten als Mittelwertfrei, ihre Auswirkung auf den Messwert kann durch Mittelwertfilterung reduziert werden. Der Nachteil ist dafür ein späterer Fertigstellungszeitpunkt der Messung „das Ergebnis liegt vor“.

Das eine Extrem ist dabei, unveränderte „Rohdaten“, d.h. die einzelnen rauschenden Messwerte im Steuerungszyklus unverzüglich also einzeln zu verarbeiten. Das andere Extrem ist, über (annähernd unendlich) viele Messwerte zu mitteln bzw. zu glätten – dies führt zu entsprechendem Zeitverzug, für eine Regelungsschleife denkbar ungünstig. Jedoch kann dadurch der zufällige Einfluss auf das Messergebnis faktisch eliminiert werden und der Ausgabewert nähert sich dem wahren (praktisch nicht bestimmbaren) Wert immer weiter an - unter der o.a. Annahme natürlich, dass das Rauschen gleichverteilt ist und somit das Werkzeug „Filter“ auch zu diesem Zweck auf die Daten angewendet werden darf bzw. das Ergebnis nicht verzerrt.

Zwischen diesen beiden Extremen liegt der Bereich, in dem der Anwender nun in der Applikation in Ansehung von max. erlaubter Verzögerung und benötigter Glättung die Filter zu wählen hat.

Allgemein kann davon ausgegangen werden, dass je schneller ein Kanal sampelt, also je höher die Nutzdatenrate ist, desto höher wird auch sein elektrisches Eigenrauschen sein. Nicht umsonst arbeiten höchstpräzise Messgeräte mit Samplingraten im Bereich von 1/min und langsamer.

Zwei Beispiele auf einem Messbereich von ±10 V und vergleichbarer Samplingrate:

Hinweis: 24 Bits/Bitpositionen ergeben einen Werteraum von 224 = 16.777.216 digits. Da das erste Bit i.d.R. als Vorzeichen verwendet wird, verbleiben 223 = 8.388.608 digits als nutzbarer unipolarer Zahlenbereich.

Beispiel 1: 24 Bit Auflösung inkl. Vorzeichen über Messbereich ±10V → 1,19 µV/digit

Annahme: Eigenrauschen der Messelektronik von 10 Bits (die unteren 10 Bits) und damit „viele wackelnde also wenig stehende Bits“

Resultat: eine allein daraus zu erwartende Messungenauigkeit (ohne Mittelwertbildung) von 210 digits ⋅ 1,19 µV/digit = 1,2 mV

Beispiel 2: 16 Bit Auflösung inkl. Vorzeichen über Messbereich ±10 V → 305 µV/digit (also 256x schlechtere Auflösung)

Annahme: Eigenrauschen der Messelektronik von 1 Bit (15 stehende Bits)

Resultat: eine allein daraus zu erwartende Messungenauigkeit (ohne Mittelwertbildung) von 0,6 mV

Hinweis: natürlich tragen noch eine Menge anderer Faktoren wie Auflösungsschritt, Temperatur etc. zum Gesamtmessfehler bei, aber in diesem Abschnitt liegt ja der Fokus auf dem Rauschen der Elektronik.

In diesem nicht unrealistischen Beispiel wäre also der 16-Bit-Kanal effektiv genauer als der 24-Bit-Kanal.

Durch Mittelwertbildung (Statistik) über eine (hohe) Anzahl Samples könnten nun beide Beispiel-Kanäle in ihrer effektiven Messunsicherheit gesenkt werden, das ist nur von der zur Verfügung stehenden Zeit abhängig. Je länger dabei gemittelt wird, desto mehr „stehende Bits“ können aus dem verrauschten Datenstrom ermittelt werden: im obigen 16 Bit Beispiel können die 15 stehenden Bits auf 16 oder aber auch darüber hinaus 17, 18 Bits gerechnet werden, indem z.B. der Klemmeninterne Mittelwertfilter aktiviert wird – unter Inkaufnahme einer dann langsamere Updaterate bzw. hohen Signalverzögerung, entsprechend also einem Tiefpass. Diese Rechnung könnte lokal im Messgerät stattfinden (und faktisch die Ausgaberate reduzieren) oder sie muss in der zentralen PLC stattfinden.

Fazit: eine hohe digitale Auflösung ist nicht allein für gute Messqualität ursächlich, aber sinnvoll als Basis für daran anschließende anspruchsvolle Datenmanipulation mit dem Ziel möglichst schnell zu einem möglichst wahren Messwert zu gelangen.

- Die Quellimpedanz in Bezug auf die Messgeräte-Impedanz ist von großer Bedeutung für sachrichtige Messung! Eine erhöhte Quellimpedanz (hoher Ausgangswiderstand) bedeutet, dass die Quelle nur wenig Strom treiben kann. Dies hat Auswirkungen in drei Bereiche:

- Generell kann die Auswirkung des unvermeidlichen Spannungsteilers RSource/RMessgerät beobachtet werden: die messbare Signalamplitude ändert sich mitunter erheblich, wenn insgesamt „langsame“ Änderungen an einer Stelle im System (Messquelle – Messgerät) auftreten: z.B. das Gerät einer Seite ausgetauscht wird oder die Widerstände sich temperaturbedingt ändern (Selbsterwärmung, Tageslicht, …).

- Signale im NF/HF-Bereich werden durch unvermeidliche kapazitive/ induktive Kabellasten beeinträchtigt: ggf. wird eine vorgesehene Spannungsamplitude nicht erreicht, weil die Quelle aufgrund der hohen Quellimpedanz „nicht ausreichend Leistung zur Verfügung stellt“ und die „Tiefpasswirkung“ der Kabellast bei einer Wechselgröße derart in Erscheinung tritt, als das „zu wenig Zeit zur Verfügung steht, um das Signal aufzubauen“.

- Ferner können „schnelle“ Änderungen am System dazu führen, dass die leistungsschwache Quelle ggf. irritiert wird und es zu Resonanzen kommt (siehe dazu auch Hinweis auf Schwingungseffekte bei analogen 20 mA Eingängen).

- Die zuvor genannten Auswirkungen können bei Messung von kleinen Signalspannungen zu einem Problemfeld führen, dass bei leistungsarmen Quellen wie etwa Thermoelementen in Betracht zu ziehen wäre.

Beispiel: IR-Sensoren (reagieren auf Temperaturstrahlung, vergleichsweise wie Thermoelemente) sind meist hochimpedant (einige 10 kΩ) und leistungsschwach. In Verbindung mit einer Multiplex-Eingangsschaltung (Stichwort: „schnelle“ Systemänderung) und einer Standard-Thermoelementklemme kann es zu Rückwirkung auf die Verbindungsleitung kommen, eine anwendungsnahe Messung ist kaum möglich: Abhilfe schafft hier eine simultane Erfassung (z.B. EL3314-0002) oder sehr hochimpedante Messgeräte (z.B. ELM3344).

Abhilfe schafft hier eine simultane Erfassung (z.B. EL3314-0002) oder sehr hochimpedante Messgeräte (z.B. ELM3344).